发布时间:2020-12-23 07:42:10

10月27日,由麻省理工学院科技评论和Deep tech Deep tech tech联合主办、梅赛德斯-奔驰特别赠送的“全球科技青年论坛”在北京举行。该论坛汇集了国内外30多名顶尖科学家、企业家和研究人员,为600多名关注新兴技术、热爱科学事业的参与者提供了接触前沿领域专家的机会。

在“实现未来价值”一节,上海交通大学教授、小石科技联合创始人倪冰冰发表了题为《智能视频分析与未来媒体》的演讲,分享了小石科技在理解和生成计算机视觉、图像和视频方面的一些尝试。

以下是倪冰冰演讲的主要内容(基于本意删除):

大家好,我是倪冰冰,今天想和大家分享的主题是《智能视频分析与未来媒体》。

小石科技是一个比较年轻的团队。我们该怎么办?总之,我们正在利用人工智能的两大核心技术:计算机视觉和大数据技术,为相关行业提供AI整体解决方案。目前,我们已经开发了四个业务领域:金融、证券、零售和媒体。

我个人的研究领域是计算机视觉中的智能视频分析。现在我们说智能理解视频是人工智能最大的战场,也是最大的人工智能。我觉得没有多少人有异议。

其实原因很简单。比如我们人类,每天接触到的信息,70%其实是视觉信息。在信息领域,大部分信息也是视频图片的数据。这些是安全监控、辅助驾驶、智能驾驶、无人驾驶以及社交媒体上的短视频、直播等核心技术。还有很多问题,比如人脸识别、行为识别、对象检测、媒体制作、视频推荐等。

同时,智能视频理解技术也面临着巨大的挑战。我们来看几个例子。比如安防领域,安防摄像头的视频质量有时候很差,人动了会有些模糊。另外,对于同一个动作,比如拳击,不同的人做同一个动作,风格非常不同。有的人更快,有的人更慢。而且因为摄像头的高度不同,大小也不同。所以很难同时抓住大事和小事。

最后,视频量非常大,每秒钟有数千小时的视频上传到全世界的Youtube上。这么大的视频量,就算我们有NVIDIA卡也要花很长时间计算。如何减少计算量,让我们有更多的时间来计算更多的视频数据,也是一个很大的挑战。

我们团队对这些问题研究了很久,和大家分享了一些有代表性的工作。

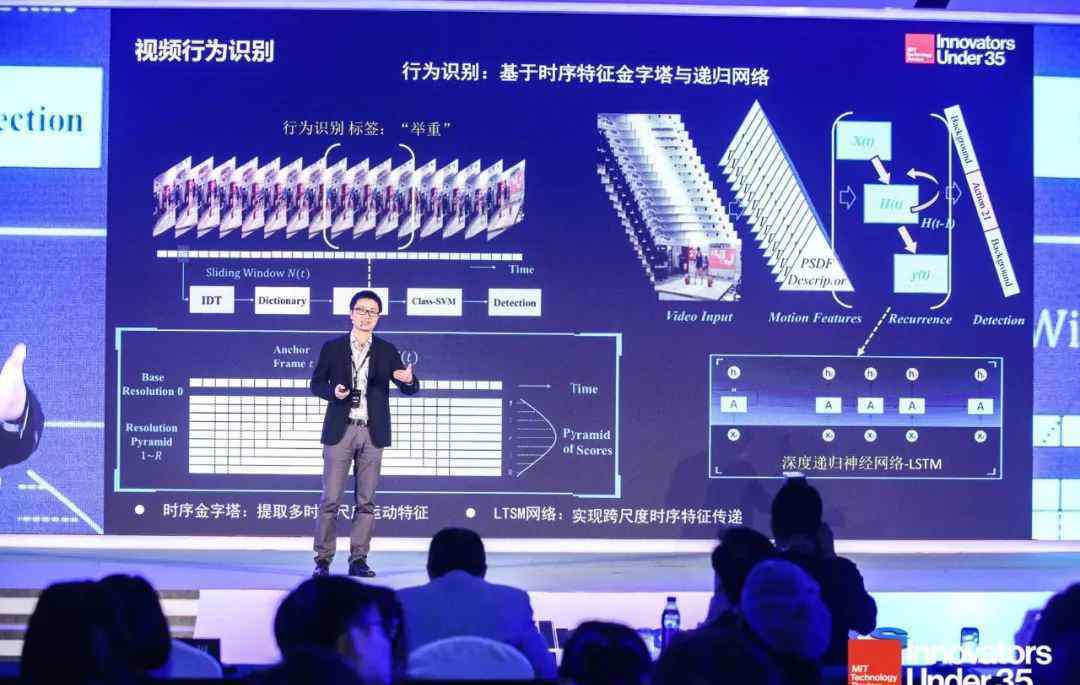

首先是行为识别。行为识别无非就是给你一个视频。你告诉观众人们在做什么,里面发生了什么。我们在这里做了一些创新,比如针对时间序列问题,我们提出了时间序列金字塔算法。该算法是在不同尺度上对时间轴进行建模,使不同尺度的特征能够得到很好的表达。我们还与流行的深度学习中的LSTM深度递归网络合作,使不同规模的信息在不同时间流动,最终达到良好的识别效果。

我们的技术还参加了2015年由谷歌、斯坦福等著名机构主办的国际行为识别测试大赛,我们有幸取得了世界上最好的成绩。

还有一个很重要的问题——行人再认,说白了就是找人。如果能在不同的摄像头下跟踪人,就能得到这个人在整个时间轴上以及空之间的轴上的分布,可以在很多应用中使用。

原来我们在视频行为中做行人识别的时候,一般都是利用单帧的信息。例如,在这个时间点,我们选择一帧图像与下一帧图像进行比较。我们发现单帧图像的信息丢失了。我拍的是人类运动的全过程。如果我们得到单帧,整个运动行为都会丢失。另外,在单帧中,可能会遇到一些问题,比如一些特殊的姿态,一些遮挡,运动模糊等。

因此,我们提出了一种方法,使我们能够在时间序列上总结整个视频的个人信息,并形成量化的表示,从而达到最佳的行人识别性能。

还有就是视频量的问题。我们现在用深度学习网络进行智能分析,参数很多,甚至超过几十、几百兆。很明显,这么大的网络用于视频分析的时间非常长。但我们也要求,在新一代人工智能中,我们希望很多智能任务都在最后进行,比如手机,iPad。很明显,这么大的模型,不能在这么小的操作装置上操作。

我们对这个问题进行了简化,使得以前用浮点数表示的网络现在用二进制数据网络表示,使得计算非常高效。

有了这项技术,其实很多必须在云和服务器上完成的人脸识别功能,现在都可以在很小的手机上完成。

我刚才说的是算法。其实对于一个公司团队来说,算法落地还有很长的路要走,在工程落地上花了相当多的功夫。

我们在人和物体检测的一些算法上做了大量的工程努力。比如我们现在有一个轻量级的人脸检测模块用于人的定位,这样一个几兆的小模块就可以在手机中运行;我们还有一个轻量级的人体骨骼检测模块;在我们找到人之后,我们需要识别他们。现在在小型设备上,人脸识别在几百万个数据库下可以达到95%以上的通过率,这是一个非常困难的过程。

在这里,我们还有一个基于多角度摄像头的3D定位跟踪模块,是行业内比较新的技术。过去,我们使用单个摄像头来定位2D场景中的人物。现在我们可以在相机之间形成匹配,利用再识别和跟踪技术在3D 空中跟踪人,并制作人的动态过程的相互图像。

这些技术已经产生了许多应用,例如,新的零售和智能零售系统就是很好的例子。新零售无非就是多少人进我店,多少男生女生,什么年龄段,在哪些产品面前呆多久,这个问题可以通过我们的技术来解决。

捕捉到这些数据后,就可以体现在我们的大数据端了。利用客流分析、轨迹和略读图等数据,商店可以布局营销布局,对营销策略进行一定的改变和优化。我们实际上在不同的场景中有许多合作伙伴。

以上提到的是我们在计算机视觉、图像和视频理解领域所做的一些尝试。与理解相对应的逆向过程是生成、图像生成和视频生成。

什么是视频生成?原来的视频是摄制组拍的,现在可以无中生有了。

当然,视频生成的问题很难,主要问题是视频是三维数据。我们针对视频生成特别困难的问题做了一些尝试。比如我们可以约束这个解的空,这样我们可以搜索的空就更小,生成的东西也就越来越逼真。我们也可以用分层的方式来处理这个解,先解决一些简单的问题,再解决一些简单的问题,从而简化整个复杂的问题。

最后,我们可以自动生成视频,现在我们可以长时间生成图像。目前,我们在世界视频生成领域取得了良好的精度。同时,我们可以生成一些交互动作。交互是一个比较困难的问题,因为交互不仅仅是表情的生成,更是他交互的动作,应该有一定的合理性。比如我出拳,他应该有闪避动作。

我们也在跨模态媒体生成方面做了一些工作。所谓跨语气词,就是我看图片能不能写一首诗,读诗能不能生成一个图像或者视频。这个问题最大的核心是不同媒体的语义空不同。我们还提出了一种称为公共子空之间匹配的技术,使得不同的媒体可以在一个公共子空内有效匹配。

最后,我们有一些有趣的结果。比如我们实现了世界上第一个让计算机算法自动观看NBA视频生成自动专业解说的案例,我们还可以通过图像自动生成一些背景音乐。这两种模式之间的转换是一个非常有趣的应用。我们相信,基于这些内容生成算法,未来新媒体时代一定会到来。在新媒体中,所有内容都是由计算机或计算机辅助人生成的。

最后,认同和生成其实是同一个问题的两个方面。有了好的识别算法和方法,也能很好的生成,有了生成算法,也能辅助识别。

在未来,我们相信认同和生成这两个任务一定会像周的左右斗争那样互相促进,最终达到非常高级的技巧。

-结束-

欢迎分享转载 →倪冰冰 上交大倪冰冰教授:对视频的智能理解是AI最大的战场