发布时间:2020-08-04 14:14:50

新智元推荐

Hugo Larochelle是谷歌大脑的研究员、深度学习领域的专家。他在最近的演讲中讨论了小样本学习这个主题,概述了这个领域的一些最新进展,存在的挑战以及研究机会。

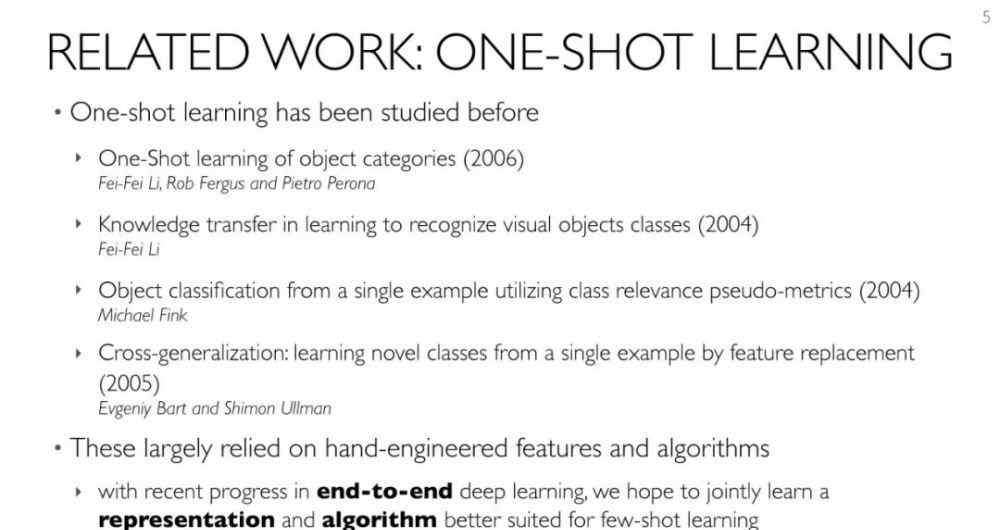

深度学习的成功部分是由于大量有标记数据的可用性。然而,即使在大数据背景下的今天,想获取具有大量优质的、标签正确的数据的数据集,仍是一个难题。

近年小样本学习(Few-shot Learning)的发展,旨在解决这个问题。小样本学习属于迁移学习的一种。顾名思义,小样本学习是一种能够让深度学习通过更少的样本学习,而不像传统的那样使用大量样本的技术。

Hugo Larochelle是谷歌大脑的研究员,深度学习领域的专家。他在最近的一个workshop中,讨论了元学习(Meta-learning)这个主题。元学习是一个非常有前途的框架,用于解决从少量数据进行泛化的问题,即所谓的小样本学习。

在元学习中,我们的模型本身就是一种学习算法:它将输入作为训练集,并输出一个分类器。对于 few-shot learning,直接训练产生的分类器具有良好的泛化性能,适用于只有非常少的标记数据的问题。

在这个workshop中,Hugo Larochelle概述了最近这个主题上取得的一些最新进展,并讨论了仍然存在的挑战和研究机会。

内容概要

元学习(Meta-learning)

选择一种Meta-learning

定义meta-learner的两种方法:

从已知的学习算法得到启发

kNN/kernel machine: Matching networks (Vinyals et al. 2016)

高斯分类器:Prototypical Networks (Snell et al. 2017)

梯度下降法:(Ravi & Larochelle, 2017) , MAML (Finn et al. 2017)

从黑盒神经网络推导

SNAIL (Mishra et al. 2018)

存在的挑战:

超越有监督分类

无监督学习、结构化输出、互动学习

超越Mini-ImageNet

对问题/数据集的分布给出一个现实的定义

Meta-Dataset

小结:

Meta-training 的分布可以产生很大的不同(至少对于目前的方法而言)

使用“常规训练”作为初始化会产生很大的不同

需要调整MAML以使其更具鲁棒性

PPT下载:

http://metalearning.ml/2018/slides/meta_learning_2018_Larochelle.pdf

新智元AI技术+产业社群招募中,欢迎对AI技术+产业落地感兴趣的同学,加小助手微信号:aiera2015_2入群;通过审核后我们将邀请进群,加入社群后务必修改群备注。

欢迎分享转载 →元学习 谷歌大脑:元学习最新进展与挑战